Biblioteca de Psicología

Inicio > Biblioteca de Psicología > Exposiciones Virtuales > La Psicología Matemática a través de sus textos > Cuestiones polémicas

La Psicología Matemática a través de sus textos PORTADA || EVOLUCIÓN HISTÓRICA || CUESTIONES POLÉMICAS || SOCIEDADES Y REVISTAS

TEMAS ACTUALES || IMÁGENES || PÓSTERES || TALLER || CONFERENCIA || BIBLIOGRAFÍA || DOCENCIA  |

CUESTIONES POLÉMICAS: |

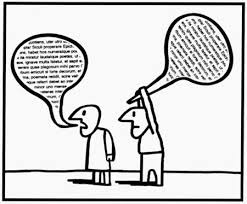

Como en toda disciplina que se precie, en Psicología Matemática han abundado los debates polémicos. Algunos de ellos han sido el de componentes principales vs. análisis factorial, la medición objetiva frente a los modelos derivados de la ley de Thurstone, la existencia y características de las variables latentes, y la propia necesidad de los contrastes de hipótesis. | | Análisis de componentes principales versus análisis factorial: | El Análisis de Componentes Principales (ACP) fue planteado en el ámbito estadístico por Pearson (1901) como una técnica que utiliza una transformación ortogonal para convertir los datos observados en un conjunto de nuevas variables denominadas componentes. El Análisis Factorial (AF) parte de los trabajos de Spearman (1904) sobre medida de la inteligencia y calcula las variables observadas a partir de factores hipotéticos, no observables. La confusión entre el AF y el ACP es un tema recurrente y que se mantiene hasta la actualidad. El AF y el ACP son dos técnicas diferentes, aunque muchos investigadores las utilicen en la práctica indistintamente. Entre las principales diferencias se encuentran las siguientes: 1) Aunque ambas técnicas tienen como objetivo transformar un conjunto de p variables observadas en otro de q nuevas variables, en el ACP, las nuevas variables (los componentes), son variables observadas y q ≤ p mientras que en el AF, las nuevas variables (los factores) son variables latentes y necesariamente q < p. 2) En el AF se asume un modelo estadístico que requiere el cumplimiento de ciertos supuestos y en el ACP no se asume un modelo estadístico ni tampoco existe el concepto de unicidad, iteraciones y convergencia. 3) El AF y el ACP tienen diferentes objetivos. Por tanto, no es raro que ofrezcan diferentes resultados. El objetivo del ACP es dar cuenta de la varianza de las variables observadas mientras que el del AF es explicar las covarianzas (o correlaciones) entre ellas. Los componentes no son constructos con significado y con una interpretación (como los factores) sino puntuaciones que capturan información eficiente sobre las variables observadas. 4) En el ACP el objetivo suele ser trabajar con las puntuaciones en los componentes, que son combinaciones lineales de las variables observadas y pueden emplearse para reemplazar a las puntuaciones en las p variables observadas; mientras que en el AF rara vez se trabaja con las puntuaciones factoriales y el objetivo es conocer la estructura de los datos y poder así plantear una teoría sobre las variables latentes. Para más detalles sobre la distinción entre el AF y el ACP véase: - Ehrenberg, A. S. C. (1962). Some questions about factor analysis. The Statistician, 12, 191-208.

- Lindley, D. V. (1964). Factor analysis. A summary of discussion. The Statistician, 14, 47-61.

- Pearson, K. (1901). On Lines and Planes of Closest Fit to Systems of Points in Space. Philosophical Magazine 2, 11, 559–572.

- Velicer, W. F., & Jackson, D. N. (1990). Component analysis versus common factor analysis: Some issues in selecting an appropriate procedure. Multivariate Behavioral Research, 25, 1-28. Disponible en papel en la UAM

- Widaman, K. F. (2007). Common factors versus components: Principals and principles, errors, and misconceptions. En R. Cudeck & R. C. MacCallum (Eds.), Factor analysis at 100: Historical developments and future directions (pp. 177-203). Mahwah, NJ: Lawrence Erlbaum Associates.

| | Medición objetiva: | Una de las grandes polémicas en Psicología Matemática se refiere al debate sobre la imposibilidad de medir atributos psicológicos. Por ejemplo, en el ámbito del AF, la existencia, sentido y arbitrariedad de los factores ha sido objeto de polémica por su carácter no objetivo. Los autores más cientificistas los consideraron entelequias cuasi-místicas. Esta polémica ha renacido en diferentes ocasiones bajo distintos enfoques. En los años 60 del siglo XX, Rasch planteó el concepto de medición objetiva como vía de solución. La medición de los conocimientos y actitudes de las personas es específicamente objetiva cuando no depende de qué instrumentos (tests, escalas, etc.) se hayan aplicado para medirlos. Los modelos matemáticos que permiten la medición objetiva son los que poseen estadísticos suficientes para estimar el nivel de rasgo del sujeto. Constituyen lo que se conoce como familia de Rasch. Los defensores de la familia de Rasch formaron un grupo homogéneo en Psicometría que descartaba el resto de enfoques. Con el tiempo esta polémica se ha diluido debido a que los modelos de Rasch suelen ajustar peor a los datos que otros modelos más generales. Aun así, son ampliamente utilizados en la práctica por su sencillez y facilidad de interpretación. - Rasch, G. (1961). On general laws and the meaning of measurement in psychology. Proceedings of the fourth Berkeley symposium on mathematical statistics and probability, 4, 321-333. Recuperado en http://econ.ucsb.edu/~doug/245a/Papers/Meaning%20of%20Measurement.pdf

- Rasch, G. (1977). On specific objectivity. An attempt at formalising the request for generality and validity of scientific statements. Danish Yearbook of Philosophy, 14, 58-94.

| | Validez de constructo: | La medición de atributos psicológicos toma un nuevo aspecto bajo la etiqueta de validez de constructo, menos centrado en las propiedades numéricas de las escalas y con más énfasis en la estructura de relaciones entre ellas. El problema de qué miden los tests psicológicos fue haciéndose más complejo. El concepto de validez de constructo llegó a abarcar desde las relaciones de un test con otros, hasta los aspectos éticos de los tests, pasando por la interpretación de las puntuaciones, perdiendo utilidad a lo largo de los años al hacerse cada vez más vago y no proporcionar una guía de actuación clara. Messick (1989), a partir de su trabajo en el ETS, fue uno de los grandes estudiosos del concepto de validez de constructo y abogó por una visión unificada del término definiéndolo como “el concepto unificador que integra las consideraciones de validez de contenido y de criterio en un marco común para probar hipótesis acerca de relaciones teóricamente relevantes”. Más recientemente, Borsboom et al. (2004) redefinieron el concepto para hacerlo más sencillo y útil. En su propuesta, la validez de constructo implica la existencia de un atributo psicológico y su efecto causal sobre las variables observadas. Naturalmente, su propuesta no quedó libre de polémica. - Borsboom, D., Mellenbergh, G. J., & Heerden, J. v. (2004). The concept of validity. Psychological Review, 111, 1061-1071.

- Cronbach, L. J. & Meehl, P. E. (1955). Construct validity in psychological tests. Psychological Bulletin, 52, 281-302

- Messick, S. (1989). Validity. In R. L. Linn (Ed.), Educational Measurement (3rd ed., pp. 13-103). New York: American Council on Education/Macmillan.

| | El sentido de las variables latentes: | El problema del sentido de los factores vuelve a aparecer a partir de los trabajos de Michell (2000) basados en la teoría de la medición. Michell considera que la psicometría da por hecho la existencia de factores cuantitativos sin tener argumentos que lo justifiquen. Propone en su lugar recurrir a procedimientos bien fundamentados en teoría de la medición, como la teoría de la medición conjunta. Borsboom et al. (2003) intentan responderle a partir de argumentos filosóficos acerca del sentido de las variables latentes, y de argumentos estadísticos sobre la comprobación de modelos mediante bondad de ajuste. Una vez más la polémica no queda cerrada, en parte por la aparente incapacidad de los teóricos de la medición para pasar del plano de la definición conceptual al desarrollo práctico de procedimientos útiles. - Borsboom, D., Mellenbergh, G. J., & Heerden, J. v. (2003). The theoretical status of latent variables. Psychological Review, 110, 203–219.

- Michell, J. B (1997). Quantitative science and the definition of measurement in psychology. British Journal of Psychology, 88, 355–383.

- Michell, J. (2000). Normal science, pathological science and psychometrics. Theory & Psychology, 10, 639-667. Recuperado en http://citeseerx.ist.psu.edu/viewdoc/download?doi=10.1.1.202.2742&rep=rep1&type=pdf

- Michell, J. (2012). Alfred Binet and the concept of heterogeneous orders. Frontiers in Psychology, 3, 1-8. Recuperado de: http://www.frontiersin.org/Quantitative_Psychology_and_Measurement/10.3389/fpsyg.2012.00261/abstract

- Woldstein, H. & Wood, R. (1989). Five decades of item response modeling. British Journal of Mathematical and Statistical Psychology. 42, 139-167.Disponible en papel en la UAM

| | Escalas de medida y teoría de la medición: | El problema de la medición de atributos psicológicos también se planteó a principios del siglo XX como reacción a los trabajos de Fechner sobre psicofísica. Los positivistas consideraban que los atributos psicológicos no son medibles de la misma manera que los físicos. En este contexto surgió la teoría de la medición y sus axiomas, que no cumple la supuesta medición psicológica. Stevens (1946) respondió con la creación de la teoría de las escalas de medida y los distintos niveles de medida (nominal, ordinal, intervalo y razón). Posteriormente, Lord (1953) subrayó la irrelevancia de las escalas de medida para la estadística en un irónico artículo. Actualmente, los principios básicos subyacentes a la medición de atributos psicológicos siguen sin estar firmemente establecidos. - Cliff, N. (1992) Abstract measurement theory and the revolution that never happened. Psychological Science, 3, 186-190.

- Stevens, S. S. (1946). On the theory of scales of measurement. Science, 103, 677–80.

- Lord, F. M. (1953). On the Statistical Treatment of Football Numbers. American Psychologist, 8, 750-751.

- Zand Scholten, A., & Borsboom, D. (2009). A reanalysis of Lord's statistical treatment of football numbers. Journal of Mathematical Psychology, 53, 69-75.

| | Contraste de hipótesis: | La última polémica tiene un cariz metodológico: el uso y abuso del contraste de hipótesis. Pese a que el contraste de hipótesis ha tenido, y tiene, un papel esencial en la investigación psicológica, también ha sido objeto de numerosas críticas y ha generado un debate importante. Algunos autores, como Cohen (1994), plantean que la propia lógica del contraste de hipótesis, así como su utilización rutinaria y acrítica, ha impedido el desarrollo de la psicología como ciencia. Proponen sustituirlo por enfoques basados en la definición y medición de atributos psicológicamente relevantes en escalas estandarizadas, como en su día se hizo con el CI. Otros autores (Nickerson, 2000; Rozeboom, 1960) critican el abuso y mal uso de los contrastes y los errores de interpretación que ello conlleva, sin pretender eliminarlo por problemas relativos a su lógica interna. Dado el gran número de críticas que suscitó el contraste de hipótesis, han sido varias las alternativas que se han propuesto para superar sus problemas. Una de las más apoyadas es la de la comisión de la APA nombrada para estudiar el caso, que propuso recomendaciones sobre uso del contraste en revistas científicas (Wilkinson, 1999). Entre ellas, complementarlo con medidas de tamaño del efecto. - Cohen, J. (1994). The Earth is round (p<.05). American Psychologist, 49, 997-1003.

- Hunter, J. E. (1997). Needed: a ban on significance testing. Psychological Science, 8, 3-7.

- Nickerson, R. S. (2000). Null hypothesis significance testing: a review of an old and continuing controversy. Psychological Methods,5(2), 241-301.

- Rozeboom, W. W. (1960). The fallacy of the null-hypothesis significance test. Psychological Bulletin, 57, 416-428.

- Wainer, H. (1999). One cheer for null hypothesis significance testing. Psychological Methods, Vol 4(2), 212-213.

- Wilkinson, L. (1999). Statistical methods in psychology journals. American Psychologist, 54, 594-604.

|

|