Biblioteca de Psicología

Inicio > Biblioteca de Psicología > Exposiciones Virtuales > La Psicología Matemática a través de sus textos > Evolución histórica

La Psicología Matemática a través de sus textos PORTADA || EVOLUCIÓN HISTÓRICA || CUESTIONES POLÉMICAS || SOCIEDADES Y REVISTAS

TEMAS ACTUALES || IMÁGENES || PÓSTERES || TALLER || CONFERENCIA || BIBLIOGRAFÍA || DOCENCIA  |

EVOLUCIÓN HISTÓRICA: | En esta página se describen algunos hitos importantes en el desarrollo de la psicología matemática. Sin duda, no están todos los autores y obras importantes, todos los que están han sido indudablemente influyentes. Se ha prestado más atención a los autores clásicos, comprendidos entre el origen de la disciplina y mediados del siglo XX, al considerar que los desarrollos posteriores son demasiado recientes para ser considerados históricos. Escribir una historia de la psicología matemática es algo que aún está por hacer, pero estas breves anotaciones proporcionan un primer bosquejo sobre el desarrollo de algunas de sus líneas principales.

|

| Antecedentes: | El nacimiento de la psicología matemática suele establecerse, por fijar un hito arbitrario, en los estudios de Heinrich Weber y Gustav Fechner sobre la relación entre estímulos físicos y la sensación o percepción, en lo que se conoce como psicofísica. El estímulo (E) viene medido en una magnitud física y la sensación (S) es la reacción subjetiva producida en el sujeto que la percibe. La ley de Fechner relaciona ambas cantidades del modo:  donde c es una constante. donde c es una constante.

La ley de Fechner se basa en la ley de Weber. Sin embargo, antes de ellos Daniel Bernoulli había descubierto la misma ley en un contexto algo distinto, pero que también puede considerarse dentro del campo de la psicología matemática. Bernoulli estudiaba la relación entre el incremento de los bienes materiales que posee una persona y la satisfacción que le produce, y llegó justamente a la misma relación logarítmica expresada en la ley de Fechner. Posteriormente, Laplace denominó valor moral a la importancia que una persona atribuye a un incremento de riqueza. Aunque D. Bernoulli y Fechner llegaron a la misma ley matemática para representar fenómenos similares, existe una diferencia importante entre ambos. Bernoulli era un matemático que propuso su ley en un plano estrictamente formal. Fechner, además, realizó un importante trabajo experimental en el laboratorio para poner a prueba su ley con distintas variables sensoriales, lo que dio origen a una tradición de investigación en psicología experimental y matemática. Francis Galton, durante el siglo XIX y por influencia de la teoría de la evolución de Darwin, realizó estudios sobre la herencia de características físicas e intelectuales en poblaciones humanas. En sus estudios trabajó en el desarrollo de conceptos estadísticos que posteriormente se extendieron por muchos otros ámbitos, como la desviación típica, correlación, trabajos sobre regresión y distribuciones normales, etc. También inventó la máquina de Galton, que demuestra de forma intuitiva en qué consiste el teorema del límite central, en su aplicación a la aproximación normal a la binomial. |

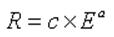

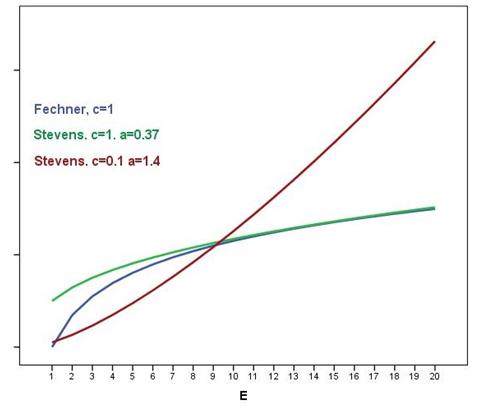

| Psicofísica y psicología experimental: | La psicofísica continuó después de Fechner por parte de autores como Stevens, ya en el siglo XX. En aquel momento el conductismo y los planteamientos empíricos habían cobrado un gran auge. En ese contexto, Stevens sustituyó el estudio de la relación entre estimulación física y percepción subjetiva por el estudio de la relación entre estímulo (E) y respuesta (R). En este caso, la respuesta no es una reacción subjetiva, como en la psicofísica del siglo XIX, sino la respuesta observable que el sujeto da para cuantificar la magnitud de un estímulo, por ejemplo, en una escala de 0 a 100 puntos. Además propuso una ley psicofísica más flexible que la de Fechner, la denominada ley potencial de Stevens, que puede adoptar una mayor variedad de formas distintas. La ley de Stevens se formula como

donde a y c son parámetros que se estiman de los datos. La siguiente gráfica permite comparar la ley de Fechner y Stevens para distintos valores de los parámetros:

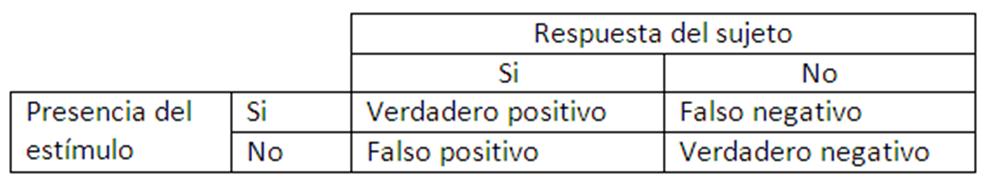

La ley de Stevens presenta el inconveniente de que no está basada en un desarrollo matemático claro como la de Fechner, sino que es más bien un modelo versátil pero basado en principios poco claros. Otra contribución importante de Stevens es la teoría de las escalas de medida. A principios del siglo XX dominaba el enfoque epistemológico positivista, que consideraba que no es posible la medición de atributos psicológicos porque no se cumplen los denominados axiomas de la medición. Stevens intentó justificar la medición en psicología mediante las escalas de medida, que se basan en la idea de que la medición puede realizarse en distintos niveles en función de las propiedades que cumplan los objetos medidos. Así el nivel más débil, el nominal, es una mera clasificación de objetos en grupos de equivalencia, mientras que habría otros niveles de medida más fuertes cuando se cumplen determinadas propiedades adicionales. En los años 50 del siglo XX surgió la teoría de la detección de señales, influida por la psicofísica y la teoría estadística de la decisión. En una situación experimental típica el sujeto pasa por varios ensayos, en los que unas veces está presente un determinado estímulo y otras no. Se trata de una situación de incertidumbre, en la que por la debilidad del estímulo, no es posible detectar con total certeza si está o no presente. Como respuesta, debe indicar si el estímulo estaba o no. Los datos recogidos en el experimento se resumen en una tabla como la siguiente.

La teoría de la detección de señales integra elementos perceptivos, relativos a la capacidad para percibir estímulos de intensidad débil, con elementos de orden superior como el criterio para decidir si el estímulo ha sido percibido. El criterio de decisión depende de las consecuencias que para el sujeto tenga dar cada una de las posibles respuestas, correctas o incorrectas, de la tabla anterior. |

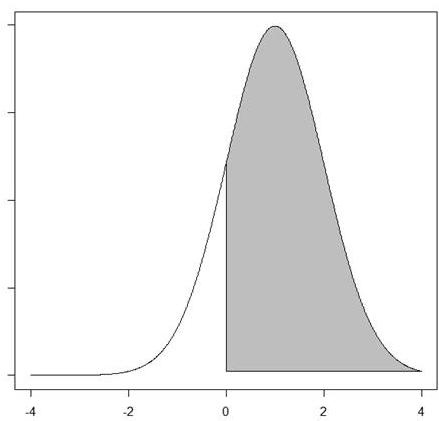

| Escalamiento: | La psicofísica iniciada por Weber y Fechner estudiaba la relación entre estímulos sensoriales y la sensación que producen. Thurstone amplió el campo de aplicación de la psicología matemática al iniciar el estudio de la valoración que los sujetos realizan de aquellos atributos psicológicos que no están asociados a una magnitud física. Por ejemplo, la clasificación de obras de arte en función de su nivel de originalidad. Para ello, utilizó el procedimiento de las comparaciones binarias como método de recogida de datos. También desarrolló procedimientos matemáticos de análisis a los que denominó ley del juicio comparativo y ley del juicio categórico. Con el paso de los años, estos métodos de análisis fueron combinados por otros autores con el análisis factorial, que Thurstone también había contribuido a desarrollar, para dar origen al análisis factorial de datos categóricos. El método de escalamiento de Thurstone permitía clasificar objetos en una única dimensión. Se basa en el concepto de proceso discriminal, que es una variable aleatoria que expresa la reacción subjetiva que se produce cuando una persona compara dos objetos y supuestamente sigue una distribución normal. Por ejemplo, si un profesor compara el grado de creatividad de dos trabajos escolares, el proceso discriminal es la diferencia entre el nivel de creatividad atribuido a cada uno de ellos. Si dicho proceso es positivo, el profesor juzgará que el primer trabajo es más creativo, y si es negativo, el más creativo será el segundo. De este modo, el valor cero actúa como un umbral. Los datos observados son dicotómicos e indican que el proceso discriminal está por encima o por debajo de cero. La siguiente gráfica muestra un ejemplo. Se trata de un proceso discriminal, X, distribuido según la normal (m=1, s=1). Cuando X ≥ 0, el primer objeto se escoge frente al segundo, por lo que la probabilidad de escoger el primero es la del área sombreada de la curva normal. Cuanto mayor sea m, más desplazada estará la curva normal hacia la derecha y será más probable escoger el primer objeto.

Los elementos básicos de esta teoría, la existencia de una reacción no observada distribuida normalmente y un umbral que permite transformar esa reacción en una variable discreta, darían posteriormente origen a la teoría de respuesta al ítem y el análisis factorial de datos categóricos. Posteriormente Warren S. Torgerson comenzó el desarrollo de los métodos de escalamiento multidimensional, que permiten clasificar objetos en varias dimensiones. Como ejemplo de aplicación, pueden mencionarse los trabajos realizados por escolares clasificados en función de su creatividad y esmero. El escalamiento multidimensional no se basa en conceptos psicológicos sino matemáticos. Utiliza procedimientos tales como mínimos cuadrados para buscar los valores de los objetos en las dimensiones subyacentes que más se aproximan a los datos observados. | - Bock, R. D. y Jones, L. V. (1968). The measurement and prediction of judgment and choice. San Francisco. Holden Day.

|

| | Análisis factorial: | El análisis factorial es una técnica estadística de reducción de datos que permite explicar las correlaciones entre las variables observadas en términos de un número menor de variables no observadas denominadas factores. Se originó en la Psicometría y es una de las herramientas estadísticas más utilizadas en Psicología porque proporciona los medios para construir y evaluar modelos teóricos que involucran constructos psicológicos como la inteligencia, personalidad, actitudes, etc. El origen del análisis factorial se atribuye a Charles Spearman (1904) en su clásico trabajo sobre inteligencia, donde distingue un factor general (el factor g) y cierto número de factores específicos (las unicidades). - Burt, C. (1909). Experimental tests of general intelligence. British Journal of Psychology, 3, 94-177.

|

Posteriormente, Louis L. Thurstone, en la universidad de Chicago, extendió el modelo del “factor común” de Spearman para el caso de múltiples factores. También introdujo el concepto de “estructura simple” y “rotación factorial” que el propio Mariano Yela (1949) aplicaría en uno de sus trabajos. Más tarde, Kaiser (1958) desarrollaría el método Varimax para realizar rotaciones ortogonales mediante procedimientos matemáticos. Thurstone fue un autor clave para la Psicometría y el análisis factorial pues fue el fundador del Laboratorio de Psicometría de Thurstone, en 1929 y el primer presidente de la Psychometric Society, en 1935. Al mismo tiempo, el estudio de los factores de inteligencia fue continuado por autores ingleses como Cyril Burt, que investigó la herencia de la inteligencia, y Godfrey Thomson, que publicó uno de los primeros compendios sobre el modelo factorial múltiple. - Spearman, C. E. & Jones, L. W. (1951). Human abilities. London: Macmillan.

- Thomson, G. H. (1939). The factorial analysis of human ability. New York. Houghton Mifflin.

- Thurstone, L. L. (1934). The vectors of mind. Psychological Review, 41, 1-32.

- Thurstone, L. L. (1947). Multiple factor analysis. Chicago: The University of Chicago Press.

- Yela, M. (1949). Application of the concept of simple structure to Alexander's data. Psychometrika, 14, 121-135. Disponible en papel en la UAM

|

Aunque el análisis factorial emergió dentro de la Psicología, las principales extensiones matemáticas del modelo factorial fueron desarrolladas desde la Estadística (Mulaik, 1972). Lawley y Maxwell (1963) desarrollaron la estimación por máxima verosimilitud y el estadístico de bondad de ajuste, chi-cuadrado, mediante razón de verosimilitud, dando al análisis factorial una base formal rigurosa. Estos desarrollos en los métodos inferenciales permitirían evoluciones posteriores del modelo, como el análisis factorial confirmatorio (Jöreskog, 1969), el análisis factorial multi-grupo (Alwin, y Jackson, 1981), el análisis factorial con estructura de medias (Sörbom, 1981) y, más recientemente, los modelos de ecuaciones estructurales. Estos desarrollos se han extendido de la Psicología a otros campos como la economía, sociología, medicina, etc. - Alwin, D. F., & Jackson, D. J. (1981). Applications of simultaneous factor analysis to issues of factorial invariance. En D. D. Jackson & E. P. Borgatta (Eds.), Factor analysis and measurement in sociological research: a multidimensional perspective (pp. 249-280). Beverly Hills, CA: Sage.

- Jöreskog, K.G. (1969). A general approach to confirmatory maximum likelihood factor analysis. Psychometrika, 34, 183-202 Disponible en papel en la UAM

- Lawley, D. N., & Maxwell, A. E. (1963). Factor analysis as a statistical method. London: Butterworth.

- Mulaik, S. A. (1972). Foundations of factor analysis. New York: McGraw-Hill.

- Sörbom, D. (1981). Structural equation models with structured means. En K.G. Jöreskog & H. Wold (Eds.): Systems under indirect observation: causality, structure and prediction. Amsterdam: North-Holland Publishing

- Thurstone, L. L. (1947). Multiple factor analysis. Chicago: The University of Chicago Press.

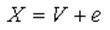

| | Psicometría: | La psicometría, al igual que el análisis factorial, tiene su origen en los trabajos de Spearman sobre medida de la inteligencia. Spearman planteó que la inteligencia es una característica que no puede medirse de manera inmediata, sino únicamente a través de una gran cantidad de manifestaciones observables de la misma. El resultado de estas características observables, desde pruebas perceptivas hasta resolución de problemas complejos, depende en parte de la inteligencia y en parte de otros aspectos específicos de la tarea en cuestión. De este modo, quedaron instaurados algunos conceptos fundamentales de la medición psicológica, la consideración de atributos no observables, que de modo parcial ejercen influencia sobre una variedad de variables observables que solo tienen interés en cuanto que manifestaciones de dicho atributo latente. Estos planteamientos son el origen tanto del análisis factorial como de la teoría clásica de tests. El análisis factorial evolucionó hacia la búsqueda de los factores primarios que explican el funcionamiento intelectual. Según la analogía que estableció Thurstone, al igual que en la ciencia óptica existen tres colores primarios a partir de los cuales se obtienen todos los demás, en psicología es necesario buscar las funciones intelectuales básicas (vectores de la mente, en la terminología de la época) cuya combinación da origen a todas las demás. Esta es la filosofía básica en la que se movía el análisis factorial hasta finales de los años 40 del siglo XX, relacionada ante todo con su planteamiento psicológico. A partir de esa época, el campo del factorial empezó a estar dominado por autores provenientes de la estadística, y por temas tales como el desarrollo de la estimación por máxima-verosimilitud, métodos de bondad de ajuste, etc., que le permitieron ganar en el reconocimiento de un rigor científico que antes se le negaba. Por el contrario, el surgimiento de la psicología cognitiva, que hizo perder vigencia a los planteamientos del intelecto basados solamente en factores latentes y el deslizamiento del campo hacia posiciones meramente matemáticas o estadísticas, hizo que el análisis factorial desistiera en sus planteamientos sustantivos iniciales. Por su parte, la teoría clásica de tests trata sobre las propiedades estadísticas de las puntuaciones en los tests mentales, con independencia de qué rasgo psicológico están midiendo. Los conceptos fundamentales son los de fiabilidad y validez. La fiabilidad mide el grado en que las variables observadas están influidas por el atributo que pretenden medir, y la validez trata sobre qué están midiendo los tests. Para abordar estos problemas se basa en un modelo lineal muy sencillo, en el que la puntuación observada en un test, X, depende de la puntuación verdadera, V, supuestamente identificada con el atributo a medir, más un error aleatorio, e, debido a aquellos elementos que contaminan la respuesta pero que no son el atributo que se desea medir. Estas cantidades se relacionan del modo:

El propósito es proporcionar una guía que permita valorar el funcionamiento de un test, o el modo en que éste debe construirse, pero en sí misma no tiene un contenido psicológico. Gulliksen (1950) escribió el que posiblemente sea el mejor compendio de la teoría clásica de tests hasta la primera mitad del siglo XX. Esta teoría resultaba poco satisfactoria cuando los datos observados vienen expresados en escalas discretas con pocas categorías de respuesta, como datos de acierto-error o acuerdo-desacuerdo. Para solucionarlo, Birnbaum planteó un nuevo modelo que combina características del escalamiento clásico, análisis factorial y teoría clásica de tests. Es lo que se conoce como teoría de respuesta al ítem y su planteamiento fundamental, junto con otro compendio clásico de teoría clásica de tests, fue publicado por Lord y Novic (1968). Durante la segunda mitad del siglo XX, la teoría de respuesta al ítem estuvo dominada por dos grandes escuelas. La primera se basaba en los modelos de ogiva normal y logísticos desarrollados por Birnbaum y Lord, y que tomaban como base la ley del juicio comparativo desarrollada por Thurstone en el contexto del escalamiento. La segunda escuela fue creada por el estadístico danés George Rasch y desarrollada por Erling Andersen, basada en el concepto de objetividad específica y la existencia de estadísticos suficientes. Los modelos de Rasch se basan en la consideración de que la definición de un atributo psicológico no debe venir determinada por qué instrumentos, o ítems, se hayan empleado en su medición. Este requisito se tradujo, estadísticamente, en la existencia de estadísticos suficientes para los parámetros del modelo: los niveles de atributo y la dificultad de los ítems. Los modelos de Rasch se caracterizan por su sencillez de interpretación, y tuvieron gran difusión por centro Europa, con algunas ramificaciones en Norteamérica (la escuela de Chicago, de Wrigth) y Australia (por ejemplo, Geoff Masters). Simultáneamente a estos desarrollos, Lazarsfeld elaboró el análisis de clase latente en el contexto de la sociología, que posteriormente habría de tener influencia en la medición psicológica. Los modelos de medida tradicionales en psicología, teoría clásica de tests, análisis factorial y teoría de respuesta al ítem, están orientados a aquellos casos en que se considera que los atributos latentes vienen expresados por variables continuas. Así por ejemplo, el estudio de la relación entre el ítem y el total del test, tanto si se basa en correlaciones de Pearson como en regresiones no lineales, parte de la consideración de un atributo continuo. Los modelos de clase latente surgen de problemas tales como el análisis de las respuestas a encuestas de opinión, y considera que el atributo medido por las variables observadas está expresado en una escala nominal. De este modo, el resultado es una clasificación de los sujetos en grupos exclusivos y no ordenados, en lugar de una ordenación de mayor a menor nivel de conocimientos o actitudes, como en los otros modelos. - Cronbach, L. J. (1951). Coefficient alpha and the internal structure of tests. Psychometrika, 16, 297-334. Disponible en papel en la UAM

- Gulliksen, H. (1950). Theory of mental tests. New York: John Wiley and Sons.

- Guilford, J. P. (1954). Psychometric methods. New York: McGraw Hill.

- Krantz, D. H., Luce, R. D., Suppes, P., & Tversky, A. (1971). Foundations of measurement. New York, NY: Academic Press.

- Lazarsfeld. P. F. & Henry, N. W. (1968). Latent structure analysis. New York: Houghton Mifflin.

- Lord, F. L. & Novic, M. R. (1968). Statistical theories of mental tests scores. Reading, MA. Addison-Wesley Publishing Company, Inc.

- Rasch, G. (1960). Probabilistic models for some intelligence and attainment tests. Copenhagen. Denmarks paedagogiske institut. Expanded edition (1980) with foreword and afterword by B.D. Wright. Chicago: The University of Chicago Press.

|

| Teoría matemática del aprendizaje y teoría de la decisión: | Los trabajos en el campo de la teoría matemática del aprendizaje datan de la primera mitad del siglo XX. Influidos por la psicología conductista, trataban de buscar funciones matemáticas que expresaran como la ejecución de una tarea evoluciona a lo largo del tiempo. El concepto fundamental en estos trabajos es el de curva de aprendizaje. A modo de ejemplo, Wiley y Wiley (1937), utilizan polinomios para representar el número de errores acumulados en una tarea a lo largo del tiempo. Posteriormente, los modelos de aprendizaje fueron ganando en sofisticación de distintas maneras. Una de ellas es mediante la introducción de la matriz de consecuencias, de modo análogo a como se utiliza en la teoría de la detección de señales. La matriz de consecuencias indica el beneficio, o pérdida, que el sujeto recibe en una tarea de identificación, en función de los aciertos y errores que comete a la hora de detectar un estímulo. Los modelos de aprendizaje ponen el énfasis en el cambio en la probabilidad de acierto en una tarea de este tipo a lo largo del tiempo. La teoría de la decisión tuvo su origen a mediados del siglo XX. Su propósito es el estudio de la elección de una alternativa a partir de un conjunto predefinido de dos o más elementos. Se trata de una teoría abstracta sobre la conducta de elección que aparece en campos tales como la psicofísica, aprendizaje y estudios de preferencias. En otras disciplinas como la psicometría también aparecen tareas de elección. Por ejemplo, en los ítems de opción múltiple, que constan de una alternativa correcta y varias incorrectas. Sin embargo, la psicometría y la teoría de la decisión tratan sobre distintos aspectos; la primera se interesa por la construcción de escalas para ordenar a los sujetos por su nivel de competencia, y la segunda por la conducta de elección en sí misma. La teoría de la decisión tuvo un gran desarrollo posterior, cuando se extendió a la economía y autores como Kahneman y Tversky comenzaron a estudiar la conducta de elección en situaciones de riesgo e incertidumbre, así como los heurísticos en el razonamiento y la elección. Estos últimos trabajos venían a poner en cuestión el modelo de conducta económica basado en el principio de racionalidad, que asume que las personas actúan en ámbitos económicos para lograr un beneficio máximo al menor coste. Otra línea de desarrollo de la teoría de decisiones han sido los árboles de decisiones, que han tenido aplicación en psicología cognitiva y psicometría. Representan el proceso de elección de una alternativa como una secuencia de decisiones que puede representarse como un árbol en teoría de grafos. - Ashby, F. G. (1992). Probabilistic multidimensional models of perception and cognition. Hillsdale, NJ: Lawrence Erlbaum Associates.

- Atkinson, R. C., Bower, G. H., & Crothers, E. J. (1965). An introduction to mathematical learning theory. New York, NY: Wiley.

- Batchelder, W. H. & Riefer, W. H. (1999). Theoretical and empirical review of multinomial process tree modeling. Psychonomic Bulletin and Review, 6, 57-86.

- Bock, R. D. & Jones, L. V. (1968). The measurement and prediction of judgment and choice. San Francisco: Holden-Day.

- Bush, R. R. & Mosteller, F. (1955). Stochastic models for learning. New York, Wiley.

- Estes, W. K. (1950). Towards a statistical theory of learning. Psychological Review, 57, 94-107.

- Kahneman, D., & Tversky, A. (1979). Prospect theory: An analysis of decision under risk. Econometrica, 47, 263–299.

- Kahneman, D., & Tversky, A. (1982). Judgment under Uncertainty: Heuristics and Biases. Cambridge. Cambridge University Press.

- Kahneman, D., & Tversky, A. (2000). Choices, values and frames. Cambridge. Cambridge University Press.

- Kahneman, D. (2011). Thinking, fast and slow. New York. Farrar, Straus and Giroux.

- Luce, R. Duncan.(1959). Individual choice behavior : a theoretical analysis. Mineola, N.Y. : Dover Publications.

- Tversky, A. & Sattath, S. (1979). Preference trees. Psychological Review, 86, 542–573.

- Wickens, T. D. (1982). Models for behavior Stochastic processes in psychology. San Francisco, W. H. Freeman and Company

- Wiley, L. E. & Wiley, A. M. (1937). Studies in the learning function. Psychometrika, 2, 107-120. Disponible en papel en la UAM

|

|